神奇DeepSeek:6710亿参数AI大佬全军覆没,惊人训练成果只需1/10算力

AI巨头惊人失败!6710亿参数深度学习项目惊现逆袭奇迹

智慧科技

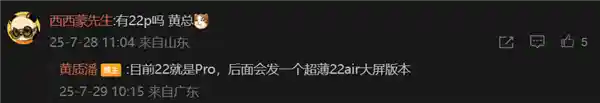

DeepSeek新版模型正式发布,技术大佬们都转疯了!

DeepSeekV3在发布时就选择了完全开源的方式,这不仅延续了其“便宜大碗”的特点,还在一份长达53页的论文中详细披露了整个训练过程和技术细节。这种开放的态度无疑为研究者们提供了极大的便利,使得技术进步的步伐得以加快。同时,这也体现了项目团队对推动行业发展的责任感和决心。通过这样的方式,DeepSeekV3不仅能够获得更多的技术支持和改进意见,还能够促进整个领域内的知识共享和技术创新。

怎么说呢,QLoRA一作的一个词评价就是:优雅。

具体来说,DeepSeekV3是一款拥有6710亿参数的MoE(专家门控)模型,其中激活参数达到了370亿。该模型在14.8万亿高质量语料上进行了预训练。这款模型的发布无疑为人工智能领域注入了新的活力,其庞大的参数规模和高效的训练方式展示了当前技术的巨大进步。随着这类高级模型的发展,我们期待看到更多创新的应用场景和突破性的研究成果。

在多项测评中,DeepSeekV3已经达到了开源领域的最先进水平,甚至超过了Llama 3.1405B。它展现出了与顶级模型如GPT-4o、Claude3.5Sonnet等相抗衡的能力。 这样的成就无疑为人工智能领域注入了新的活力。DeepSeekV3不仅展示了其技术上的突破,还意味着开源项目在某些方面已经能够与商业巨头的产品相媲美。这不仅有助于推动整个行业的进步,也为开发者提供了更多选择,使得他们可以根据自身需求选择最适合的技术方案。同时,这也预示着未来开源模型在性能上有望进一步缩小与顶级封闭模型之间的差距,为AI技术的普及和应用开辟了新的道路。

其价格比Claude 3.5 Haiku还便宜,仅为Claude 3.5 Sonnet的9%。

更重要的是,众人迅速在论文中找到了关键细节:

DeepSeekV3整个训练过程仅耗时不到280万个GPU小时,相比之下,Llama3405B的训练时长则达到了3080万GPU小时(注:所使用的GPU型号不同)。

直观地从资金投入上进行比较,训练671B的DeepSeekV3需要耗费557.6万美元(约4070万人民币),相比之下,仅训练一个7B的Llama2模型就需要支出76万美元(约555万人民币)。

OpenAI创始成员Karpathy对此赞道:

DeepSeekV3使得在有限的算力预算下进行模型预训练变得更加简单易行。 这款工具的推出无疑为众多科研机构和企业带来了福音,尤其是在硬件资源相对紧张的情况下,依然能够有效开展大规模的模型预训练工作。这不仅降低了深度学习技术的入门门槛,也极大地促进了人工智能领域的研究与发展。未来,随着技术的不断进步和优化,相信DeepSeekV3将在更多应用场景中发挥重要作用,进一步推动人工智能技术的普及与应用。

DeepSeek V3看起来比Llama 3 405B更强,训练消耗的算力却仅为后者的1/11。

Meta科学家田渊栋也惊叹DeepSeek V3的训练看上去是“黑科技”:

这是非常伟大的工作。

全网热烈实测中

先来看官方说法,新模型这次主要有以下几个特点:

从模型能力的角度来看,其评测得分不仅超越了Qwen2.5-72B和Llama-3.1-405B等开源模型,甚至与一些顶级闭源模型(如GPT-4o及Claude-3.5-Sonnet)相比也毫不逊色。

从实际响应来看,其生成速度提升了3倍,每秒生成60个tokens。

在又快又好的同时,DeepSeek V3的API价格也被打下来了。

每百万输入tokens 0.5元(缓存命中)/ 2元(缓存未命中),每百万输出tokens 8元

单论价格,正如一开始提到的,它几乎是Claude 3.5 Sonnet的1/53(后者每百万输入3美元、输出15美元)。

而如果要平衡性能和成本,它成了DeepSeek官方绘图中唯一闯进“最佳性价比”三角区的模型。

对了,DeepSeek这次还搞了一个45天优惠价格体验期,也就是在2025年2月8日之前,所有用户使用DeepSeek V3 API的价格分别下降了80%(输入命中)、50%(输入未命中),75%(输出)。

据最新数据显示,每百万个输入token的处理费用为0.1元(当缓存命中时)或1元(当缓存未命中),而每百万个输出token的费用则为2元。 这种定价策略在一定程度上反映了当前技术成本和市场需求之间的平衡。对于用户而言,提高缓存命中率不仅能够有效降低成本,还能提升系统的响应速度,从而获得更好的使用体验。而对于服务提供商来说,则需要不断优化算法和系统架构,以降低缓存未命中的概率,进而控制运营成本。这种机制无疑推动了技术和服务的持续进步。

最后,本次官方同步开源了原生FP8权重,并提供了从FP8到BF16的转换工具。

具体而言,SGLang和LMDeploy这两个框架已经实现了对FP8推理的支持,这无疑为低精度计算提供了强有力的支持。而TensorRT-LLM和MindIE则在BF16推理方面表现出色,这使得它们在追求更高精度的应用场景中更具优势。 这些技术进步表明,不同的深度学习框架正在针对不同需求进行优化。FP8格式在节省计算资源和提高运行效率方面表现突出,适合那些不需要极高精度的应用场景。相比之下,BF16格式虽然在精度上有所牺牲,但在需要高精度处理的任务中仍然能够提供更好的性能。这些框架的发展不仅反映了技术的进步,也体现了开发者对实际应用需求的深刻理解。

目前,普通用户已经可以通过官方网站(chat.deepseek.com)与DeepSeekV3进行互动交流。同时,API也已同步更新,用户无需对现有的接口配置做出任何更改。 这一消息无疑为众多依赖DeepSeek技术的开发者和企业带来了极大的便利。无需改动现有接口配置,意味着用户可以无缝地享受到新版模型带来的改进和优化。这不仅简化了操作流程,也为新技术的普及和应用提供了强有力的支持。对于广大用户而言,这意味着他们能够更加专注于内容的创作和创新,而不必被繁琐的技术细节所困扰。同时,这也反映了DeepSeek团队在技术迭代和服务优化上的高效与专业。

知名AI博主AK亲测,只需几行代码就能将它部署到Gradio。

Okk,话说到这里,我们直接来看一些实测效果吧。

首位全职提示词工程师出新题,DeepSeek V3完全答对

这第一关,来自首位全职提示词工程师Riley Goodside。

近日,一项新的挑战题目“Which version is this?”引起了广泛关注,旨在测试不同AI模型对自身版本的认知能力。参与这项挑战的选手包括DeepSeekV3、Claude、Gemini、ChatGPT和Grok。 这项挑战不仅考察了各款AI模型的技术水平,也反映了它们在自我认知方面的差异。从某种角度来看,这种测试或许能帮助我们更好地理解这些人工智能系统的自我意识和元认知能力。在当前的人工智能技术发展过程中,这样的测试显得尤为重要。它不仅可以促进技术的进步,还能让我们更深入地了解AI系统的工作机制及其潜在的应用领域。未来,随着技术的不断演进,我们期待看到更多类似有趣的挑战,以进一步推动人工智能技术的发展。

先说结论,按照Riley的观点,这几个人的回答各有特色,不尽相同,但令人惊讶的是,DeepSeekV3竟然完全答对了。 这种现象引发了我对人工智能能力的新思考。DeepSeekV3能够准确无误地给出答案,说明其在处理复杂问题上的能力已经相当成熟。同时,这也提示我们,在评估人类与机器的表现时,需要更加细致地考量各自的优势和局限性。也许未来的人机协作模式会因此而发生一些有趣的变化。

Claude3.5Sonnet对其版本信息了若指掌——不仅准确地说出了版本号(很多用户非正式地称之为3.5.1或3.6版),还提到了发布月份。

(不过Claude 3.5 Haiku出错了,误识别为Claude 3 Haiku。)

不过后面几位选手就开始各种出错了,尤其是ChatGPT和Grok。

ChatGPT最近的表现似乎有些不稳定,有时会给出模糊的答案,这可能是因为它采用了GPT-4架构。有时候,它甚至会自信地提供错误的信息。这种情况让人感到困惑,也引发了对AI系统准确性和可靠性的担忧。尽管如此,AI技术的进步仍然值得肯定,但在实际应用中仍需谨慎使用,特别是在需要高度准确信息的领域。

而Grok尤为特别,虽然有一整套理论体系,但却未曾提及其具体版本。(除非你直接询问它使用的是哪个Grok模型)

除此之外,一些网友还进行了更多测试。

更多网友整活

比如Tom小哥惊讶地表示,DeepSeekV3无需开发者进行详细解释,便能“神秘”地理解整个项目。 这样的技术进步确实令人感到震惊。毋庸置疑,DeepSeekV3在人工智能理解和处理复杂任务方面展现出了显著的能力。这不仅意味着开发效率的大幅提升,还可能预示着未来人机协作的新模式。不过,随之而来的还有对技术透明度和可解释性的担忧。如何确保这类高度自主的人工智能系统能够被正确使用,并且不会因为其“神秘”的工作方式而引发潜在的风险,将是未来需要认真考虑的问题。

突然感觉机器里好像有鬼:

他唯一做的,就是告诉DeepSeek V3最终目标是什么。

当然,老规矩还是要测一下数草莓中的“r”以及“9.9和9.11哪个大”这种行业难题。(doge)

很欣慰,这次所有答案都是正确的,并且答案及分析过程均无问题。

最后,还有人直接将4个M4 Mac mini堆叠在一起来运行DeepSeek V3了……

唯一令人惋惜的是,目前的DeepSeekV3版本尚不支持多模态的数据输入和输出功能。

模型预训练:<2个月,600万美元

测试完毕,我们接着深入探讨论文中的预训练环节。这一部分目前受到了广泛的关注。

官方介绍,通过在算法、框架及硬件层面的协同优化,DeepSeekV3大幅降低了训练成本,实现了更为经济的运行模式。

预训练阶段,在每万亿token上训练DeepSeekV3仅需要18万GPU小时,这意味着,在官方2048卡集群上,短短3.7天便能完成这一训练过程。这不仅展示了该模型在大规模数据处理上的高效性,也反映了当前人工智能技术在资源优化方面的显著进步。如此高效的训练时间,无疑将大大加速模型迭代和技术创新的步伐,为未来的应用提供更加坚实的基础。

研发团队用了不到2个月的时间就完成了DeepSeek V3的预训练,耗费了266.4万GPU小时,再加上上下文长度扩展的11.9万GPU小时,和后训练的5000 GPU小时,总训练成本为278.8万GPU小时。

假设GPU租赁价格为每GPU小时2美元,那么总成本将达到557.6万美元。这一数字令人震惊,尤其是在当前科技行业竞争如此激烈的背景下。随着人工智能技术的发展,对GPU计算能力的需求不断增加。这种高成本可能意味着只有大型企业和资金雄厚的初创公司才能负担得起这样的开销,而小型企业或研究机构可能会因此受到限制。这不仅加剧了技术资源的不平等分配,还可能减缓创新的步伐。如何平衡成本与技术发展之间的关系,将是未来科技界需要面对的重要课题。

所以,具体是什么样的协同优化?

官方标注了几个重点:

首先,架构方面,DeepSeek V3采用了创新的负载均衡策略和训练目标。

研发团队在DeepSeek-V2架构的基础上,提出了一种不依赖辅助损失函数的负载均衡方法,旨在最大程度上减轻因负载均衡带来的性能损耗。

具体而言,该策略在MoE模型中为每个专家引入了一个偏置项,并将其加入到相应的亲和度分数中,以此来决定top-K路由的选择。这一改动无疑为模型提供了一种新的调节机制,使模型能够更灵活地调整不同专家的重要性。这样的设计不仅增强了模型的适应性,也提高了其在处理复杂任务时的表现。通过这种方式,模型可以更好地识别哪些专家对于特定任务更为关键,从而优化了资源分配,提高了整体性能。

研发团队进一步验证,采用多Token预测目标(Multi-Token Prediction, MTP)能够有效提升模型性能,并有助于实现推理过程中的推测解码加速。

预训练方面,DeepSeekV3使用FP8进行训练。研发团队开发了一种FP8混合精度训练框架,首次证明了FP8训练在超大规模模型中的可行性和有效性。

在探讨跨节点MoE(Mixture of Experts)训练中的通信瓶颈问题时,论文提出了一种名为DualPipe的高效流水线并行算法。这种算法能够在单个前向和后向块对内实现计算与通信的重叠,从而有效提升训练效率。这一创新方法不仅解决了多节点间数据传输的延迟问题,而且为大规模分布式机器学习系统的设计提供了新的思路。通过优化通信机制,DualPipe算法能够显著减少等待时间,提高整体系统的吞吐量,这对于推动深度学习模型在更大规模上的应用具有重要意义。此外,这种方法也为未来研究如何进一步降低通信开销,以及如何在保证准确性的前提下加速模型训练提供了宝贵的参考。

这种重叠设计能够确保,在模型不断扩大的过程中,只要维持固定的计算与通信比例,就能够跨节点应用细粒度专家,从而实现几乎为零的所有到所有通信开销。

另外,研发团队还开发了高效的跨节点all-to-all通信内核等。

后训练方面,DeepSeek V3引入了一种创新方法,将推理能力从长思维链模型(DeepSeek R1)中,蒸馏到标准模型上。这在显著提高推理性能的同时,保持了DeepSeek V3的输出风格和长度控制。

其他值得关注的细节在于,DeepSeekV3的混合专家模型(MoE)架构包含256个路由专家和1个共享专家。在这一体系下,每个输入的token会被激活8个专家处理,并且这些token最多只会被转发到4个不同的节点上。这样的设计不仅提高了模型的效率,还通过分散计算任务来增强系统的整体性能和稳定性。这种创新的方法为处理大规模数据提供了新的可能性,也预示着未来人工智能领域可能的发展方向。

DeepSeek V3还引入了冗余专家(redundant experts)的部署策略,即复制高负载专家并冗余部署。这主要是为了在推理阶段,实现MoE不同专家之间的负载均衡。

最后,来看部分实验结果。

大海捞针实验:

可以看到,在各项基准测试中,DeepSeek V3在开源模型中达到SOTA。

贾扬清谈DeepSeek团队:其成就根植于多年专业知识

新版本模型的发布引发了广泛讨论,DeepSeek及其背后的开发团队也受到了更多的关注。这款模型不仅在技术上有所突破,而且其应用前景也令人期待。随着对DeepSeek了解的加深,人们对其团队在人工智能领域的创新能力和前瞻性有了更深刻的认识。这一进展不仅是技术上的胜利,也是对未来智能时代的一次重要探索。 从这次事件可以看出,科技创新的力量正在不断推动社会进步。DeepSeek的成功不仅仅是一个产品的成功,更是团队智慧与努力的结晶。它展示了中国在人工智能领域日益增强的实力,同时也激励着更多科研人员投身于这个充满挑战与机遇的领域。希望未来能有更多类似的创新成果,为我们的生活带来更多便利和可能。

其中,贾扬清还透露了与DeepSeek团队早年的相处细节。

当时是2019年,他正打算向团队推荐一个AI云解决方案,并试图说服这群人:

不需要复杂的云虚拟化环境,只需要容器和高效的调度器。需要构建真正快速且相互连接的专用网络,例如RoCE或Infiniband。需要具备像NFS这样的通用存储解决方案,无需过于复杂,但必须保证高速访问。目标是让AI开发者满意,而非系统可靠性工程师(SREs)。

有意思的是,团队表示这些技术他们已经应用多年,并请求他协助向一些大学实验室捐赠计算资源。

当然最后也确实帮上忙了,而贾扬清也再次感叹:

DeepSeek团队的卓越成果在很大程度上源于多年的深厚积累,这些积累往往被很多人所忽略。

最最后,除了本次官方公布的测试结果,Imsys匿名竞技场也提前预热,引发了玩家们的热烈讨论。 Imsys匿名竞技场的新动向不仅展示了其在游戏开发领域的活跃度,也体现了玩家社区对这一平台的高度关注。从目前透露的信息来看,这一竞技场似乎准备了一系列吸引人的新功能和改进,有望为玩家带来更加丰富和公平的游戏体验。随着正式发布日期的临近,我们可以期待看到更多令人兴奋的细节逐步揭晓。

家人们,近期,随着技术的发展,一款名为DeepSeekV3的人工智能模型引起了广泛关注。这款模型在处理复杂任务方面展现出了卓越的能力。在我看来,DeepSeekV3不仅代表了人工智能领域的一项重要进展,也预示着未来可能出现更多功能强大且应用广泛的AI工具。 DeepSeekV3的出现,意味着人工智能技术正在以前所未有的速度进化,这不仅为科研人员提供了更为强大的研究工具,也为各行各业的应用开辟了新的可能性。例如,在新闻报道与分析领域,这样的技术可以大大提高信息处理的效率,帮助记者更快地获取关键数据,从而更加专注于内容的深度挖掘和分析。 然而,随之而来的也有对数据安全和隐私保护的担忧。如何在推动技术进步的同时,确保用户的数据安全和个人隐私不被侵犯,将是未来需要重点关注的问题之一。此外,随着AI工具能力的增强,其对就业市场的影响也不容忽视。社会需要提前准备,以应对可能的职业变革和挑战。 总之,DeepSeekV3的出现无疑为人工智能领域注入了新的活力,同时也带来了诸多思考。我们需要在享受科技进步带来的便利的同时,积极面对并解决伴随而来的各种挑战。

体验地址:https://chat.deepseek.com

技术报告地址:https://github.com/deepseek-ai/DeepSeek-V3/blob/main/DeepSeek_V3.pdf

抱抱脸开源地址:https://huggingface.co/deepseek-ai/DeepSeek-V3

参考链接:https://mp.weixin.qq.com/s/iFZOQsUNkpkXPDvOkE99wQ

人工智能最新资讯

2025-07-29 14:26:23

2025-07-29 14:25:15

2025-07-29 14:24:07

2025-07-29 14:22:33

2025-07-29 14:20:13

2025-07-29 14:19:32

2025-07-29 14:17:51

2025-07-29 14:15:15

2025-07-29 14:13:33

2025-07-29 14:13:10

2025-07-29 14:12:33

2025-07-29 14:11:35

2025-07-29 14:11:13

2025-07-29 14:09:33

2025-07-28 12:52:54

2025-07-28 12:29:38

2025-07-28 12:13:03

2025-07-28 12:09:13

2025-07-28 12:08:01

2025-07-28 12:07:17

2025-07-28 12:03:19

2025-07-28 11:59:42

2025-07-28 11:55:28

2025-07-28 11:55:13