全网追寻:国产超级搜索引擎 DeepSeek 引领智能思维潮流

深度探索,智能引领,全网智能搜索DeepSeek带你开启未来智能思维之旅

的家友们,蛇年吉祥!

在这个农历新年期间,科技界却并不平静...

距离OpenAI发布由GPT-3.5模型支持的ChatGPT聊天机器人,已经过去两年多时间了。

在这两年间,无论是微软、谷歌这样的科技巨头,还是迅速崛起的初创企业,都在人工智能大模型领域投入了巨大的资源。 在这个充满活力的科技竞赛中,各大公司纷纷押注于人工智能大模型的研发,这不仅反映了技术发展的趋势,也揭示了市场竞争的新格局。这些巨额投资的背后,既是对于未来科技主导权的争夺,也是对创新能力和商业潜力的考验。随着技术的不断进步,我们有理由期待,这场竞赛将为社会带来更多的便利和变革,同时也需要警惕可能带来的伦理和隐私问题。

随着算力需求不断攀升,大模型的训练和推理成本也在相应增加。

OpenAI 去年推出的 ChatGPT Pro 会员,价格已经来到了每月 200 美元。

“屠龙者终成恶龙”,每月20美元的ChatGPT Plus会员,提供的o1模型使用次数有限,仅能“浅尝辄止”,难以真正融入日常工作应用。

如果未来成本继续上升,那么AI的前景是否会是每月2000美元的“ChatGPTProMax会员”呢?

然而,最近,来自杭州的“小公司”DeepSeek引发了全网热议,其新颖的思路为整个AI行业注入了新的活力。 DeepSeek的创新理念迅速走红,不仅展示了小型企业在技术领域的潜力,还提醒我们,即便是在大企业主导的领域,新兴力量依然能够带来突破性的变革。这无疑是一个值得深思的现象,它告诉我们,未来的科技发展需要更多这样的“小巨人”。

去年年底,DeepSeek-V3模型现已发布,其多项评估成绩超过了Qwen2.5-72B和Llama-3.1-405B等其他开源模型,并且在性能上与闭源模型GPT-4o及Claude-3.5-Sonnet相当,难分高下。

作为一款开源的 MoE 混合专家模型,DeepSeek-V3 当时获得了业内人士不少的关注,但是还并没有“出圈”。

不过,在DeepSeek官方手机应用于1月初上线前,已有一些模仿应用试图借势炒作。

1月20日发布的推理模型DeepSeek-R1,在性能上实现了与OpenAI-o1正式版的对标。

此外,DeepSeek 也并没有藏着掖着,同期公开了 DeepSeek-R1 的训练技术,并且开源了模型权重。

而且对我们普通用户来说,DeepSeek-R1 直接在其官网免费开放使用。

而且,DeepSeek-R1 还可以联网搜索信息,增加了不少使用上的灵活性。

要知道,去年10月31号上线的ChatGPTSearch搜索功能目前还不支持与ChatGPT 1模型协同工作,我们只能暂时退而求其次选择使用4号模型。尽管如此,这个新功能依然为用户提供了更丰富的信息获取途径,尤其是在处理复杂查询时,它能提供更为详尽的结果。不过,期待ChatGPTSearch未来能够实现与更多版本的模型无缝协作,以进一步提升用户体验。

此外,作为一款采用CoT思维链技术的推理模型,DeepSeek-R1直接展示了其思考过程,这让我们能够直观地感受到当前大模型技术的强大之处。 这一创新不仅体现了人工智能在透明度和可解释性方面的进步,也为我们提供了更深入理解AI决策过程的机会。这种直观展示思考过程的方式,让非专业用户也能更好地理解和信任这些复杂的模型。未来,随着技术的发展,我们有理由期待更多类似的改进,使人工智能更加亲民且易于使用。

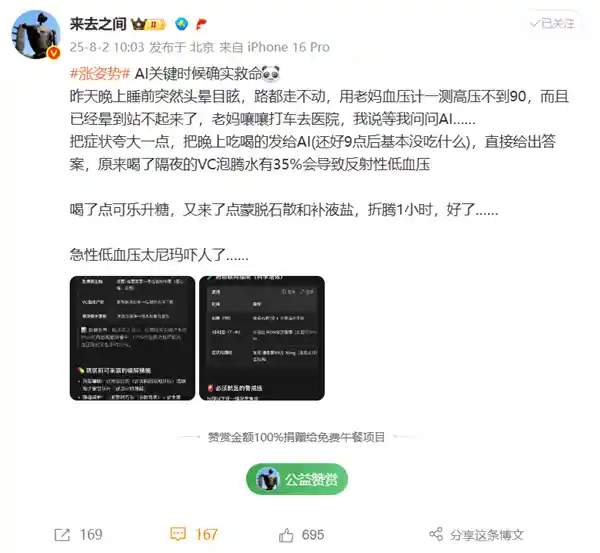

在海内外全网爆火的同时,DeepSeek 也承受了非常大的压力,相信我们不少家友都对下面这句话非常熟悉。

除了大量用户的涌入,DeepSeek 甚至还承受了大规模的恶意攻击。

要知道,即便是ChatGPT,也时常遭遇服务器故障的问题,这方面也希望用户们能够给予更多的理解和包容。 修改后的版本: 即便如ChatGPT这般先进的智能系统,依然会遇到服务器故障的情况,希望各位用户能够多一份理解和宽容。 发表的看法观点: 在当前的技术水平下,任何大型的在线服务平台都可能面临服务器故障的风险。对于这些不可避免的技术问题,用户的理解和支持是非常重要的。同时,这也提醒相关技术和服务提供商,持续优化和加强系统的稳定性和容错能力是必不可少的工作。只有这样,才能更好地服务用户,提供更加优质的服务体验。

除了671B参数的完整模型,DeepSeek还蒸馏出几款小型模型,32B和70B模型也在多项能力上达到了与OpenAIo1-mini相当的效果。

而这些经过蒸馏处理的模型,我们现在可以在自己的设备上,本地环境中进行运行测试。

DeepSeek-R1 的成本优势,便在其官方 API 服务定价中体现了出来:

每百万输入 tokens:1 元(缓存命中)/ 4 元(缓存未命中)

每百万输出 tokens:16 元

其输出API的价格甚至仅为ChatGPT 1的约3%,这背后的技术秘密在于MoE(混合专家)模型的运用。 这种成本效益极高的方式不仅展示了技术进步带来的巨大潜力,也预示着未来人工智能服务可能将以更低的成本提供更高质量的服务。MoE模型通过动态地仅激活网络中的特定部分来处理不同的任务,大大提高了效率和性能。这不仅降低了运营成本,也为用户提供了更加个性化和高效的服务体验。

前面提到,DeepSeek-R1是一款拥有671B参数的模型,按照传统观点,其运行难度不容小觑。

MoE架构的核心理念在于将复杂的任务拆解为若干个较小且更易处理的子任务,每个子任务由专门的专家网络负责解决。这种设计不仅提高了模型处理复杂任务的能力,还显著提升了计算效率。通过让不同网络专注于特定类型的数据或任务,MoE架构能够更好地应对多样化的应用场景,从而在实际应用中展现出更高的灵活性和适应性。这无疑为深度学习领域开辟了新的研究方向和应用前景,未来有望在更多领域发挥重要作用。

这样,当我们向 MoE 模型输入提示时,查询不会激活整个 AI,而只会激活生成响应所需的特定神经网络。

因此,R1和R1-Zero在处理查询时仅激活了37B参数,这远低于它们的总体参数量,只占不到十分之一。“让专业的人干专业的事”这一理念在这里得到了体现,从而显著降低了推理成本。 这样的设计不仅体现了技术上的创新,也展示了人工智能领域的一种新趋势:即通过更精细化的参数控制来实现效率的最大化。这种策略不仅可以提高运行效率,还能减少不必要的资源消耗,使得AI系统更加环保和经济。同时,这也为未来AI技术的发展提供了一种可能的方向,即如何在保持高性能的同时,进一步优化资源使用。

其实,MoE 并不是一个新概念,最早起源于 1991 年的论文《Adaptive Mixture of Local Experts》。

不过这一思路的“起飞”,还要等到 2023 年 12 月 Mixtral 8x7B 模型的推出。

外界普遍认为GPT-4采用了MoE模型,但对于已经成为“封闭AI”的OpenAI而言,其旗舰模型的诸多技术细节,我们依然不得而知......

传统的 AI 大模型训练,使用的是 SFT 监督微调过程,在精心策划的数据集上训练模型,教会它们逐步推理。

而 DeepSeek-R1 则使用 RL 强化学习的方法,完全依赖环境反馈(如如问题的正确性)来优化模型行为。

这首次展示了通过纯粹的强化学习训练,可以增强模型的推理能力。在强化学习过程中,模型自主发展出了自我验证和反思推理等复杂行为,达到了与ChatGPTo1相当的水平。

这项技术,在未来,我们在训练过程中可能不再需要耗费巨大的成本来获取大量经过细致标注的高质量数据。

尽管 DeepSeek-V3 和 DeepSeek-R1 十分强大,但他们还都是名副其实的“大语言模型”,并不具有多模态的能力。

也就是说,目前我们尚未向对方传递图片或音频等多媒体信息,他们也缺乏生成这些类型内容的能力,因此所有信息交流仅限于文本形式。这一现状使得我们的沟通方式显得较为传统,但同时也突显了文字在信息传递中的独特价值。文字能够承载丰富的思想和情感,通过精准的语言表达,依然可以实现高效且深入的信息交流。未来或许可以通过技术手段弥补这一局限,但在当前条件下,充分利用好文字的力量仍然是关键。

目前DeepSeek官方所提供的文件上传功能,实际上仅执行了文字OCR识别的过程。

不过,就在 1 月 28 日凌晨,DeepSeek 开源了全新的视觉多模态模型 Janus-Pro-7B。

不同于以往的方法,Janus-Pro通过将视觉编码过程分解为若干独立路径来克服传统框架中的某些限制,但依然使用单一的统一Transformer架构来进行处理。

这种解耦方法不仅能有效减轻视觉编码器在认知和创作阶段可能遇到的矛盾,还增强了系统的可调节性。

Janus的表现不仅超越了传统的统一模型,在与任务特定模型的对比中也展现出卓越的能力。凭借其简洁性、高度的灵活性以及高效的性能,Janus-Pro有望成为下一代统一多模态模型中的佼佼者。我个人认为,Janus-Pro的设计理念非常前瞻,它不仅能够处理多种数据形式,还能在不同应用场景中灵活切换,这无疑为其在未来市场上的成功奠定了坚实的基础。

其在 GenEval 和 DPG-Bench 基准测试中击败了 Stable Diffusion 和 OpenAI 的 DALL-E 3。

不过作为一款仅有 7B 参数的“小”模型,Janus-Pro 目前只能处理 384 x 384 分辨率的图像。

但我们相信,这仅仅是一个开始,我们对DeepSeek在未来的新思路指导下,多模态大模型的表现充满期待。

DeepSeek 的爆火,让不少 AI 大模型领域的“友商”,都没法无视这样一家“小公司”。

今天(1 月 29 日)凌晨,农历新年的钟声刚刚敲响,阿里通义团队带来了他们的“新年礼物”—— Qwen2.5-Max 模型。

通义千问团队,也在 Qwen2.5-Max 模型的介绍中提到了 DeepSeek-V3。

近期,DeepSeekV3的推出使大家认识到超大规模MoE模型的表现及其实施方式,与此同时,Qwen也在开发超大规模的MoE模型Qwen2.5-Max,该模型采用超过20万亿token的预训练数据,并结合了精心设计的后期训练方案进行训练。

与业界领先的模型(包括 DeepSeek V3、GPT-4o 和 Claude-3.5-Sonnet)相比,Qwen2.5-Max 的性能表现也相当有竞争能力。

在基座模型的对比中,与目前领先的开源 MoE 模型 DeepSeek V3、最大的开源稠密模型 Llama-3.1-405B 相比,Qwen2.5-Max 在大多数基准测试中都展现出了优势。

目前,Qwen2.5-Max已经向公众开放。这款以“Max”为定位的模型,展示了其在处理复杂任务和提供深度分析方面的能力。尽管如此,Qwen2.5-Max尚未实现开源,这可能让一些开发者和研究者感到遗憾,因为开源可以促进更多的创新和合作。但无论如何,这一发布无疑为AI技术的发展注入了新的活力,并为用户提供了更为强大的工具来探索和应用人工智能。

而与 DeepSeek-R1 的直接对决,我们可能要等到未来新版的 QwQ、QVQ 模型。

OpenAI 的 CEO 阿尔特曼也对 DeepSeek-R1 进行了评价:

针对大家对价格的不满,阿尔特曼也表示未来的ChatGPTo3-mini模型将向免费用户开放,而Plus会员则享有每天100条请求的额度。

此外,新的ChatGPTOperator功能也将很快对Plus会员开放,同时,OpenAI的下一版模型也不会仅为每月200美元的Pro会员独占,Plus会员同样可以使用。

这究竟是由于竞争对手如DeepSeek带来的压力,还是OpenAI自身在进行成本优化,我们尚不清楚。

我们期待在2025年,还有哪些关键领域的突破,AGI通用人工智能是否也即将实现。

人工智能最新资讯

2025-08-04 15:56:43

2025-08-04 15:49:26

2025-08-04 15:36:51

2025-08-04 15:35:41

2025-08-04 15:34:15

2025-08-04 15:33:03

2025-08-04 15:28:40

2025-08-04 15:25:10

2025-08-04 15:24:56

2025-08-04 15:16:19

2025-08-04 15:12:44

2025-08-04 15:11:41

2025-08-04 15:10:37

2025-08-04 15:10:13

2025-08-04 15:04:23

2025-08-04 15:03:13

2025-08-04 15:02:05

2025-08-04 15:00:04

2025-08-04 14:59:38

2025-08-04 14:57:57

2025-08-04 14:55:16

2025-08-04 14:53:07

2025-08-04 14:50:06

2025-08-04 14:49:51