发布日期:2025-07-09 08:56:16

物理隔离护航AI核心:OpenAI严控上网权限防泄密

物理隔离筑牢安全防线,OpenAI严控网络权限护航AI未来

7月9日,据媒体报道,OpenAI近期全面优化其安全机制,以防范企业间谍行为带来的威胁。此次升级的关键措施之一是实施“信息隔离”政策,旨在对员工接触敏感算法和新产品的权限进行严格管控。

例如,在开发o1模型的过程中,OpenAI规定只有经过严格审查并获得相应权限的团队成员,才可以在公共办公区域讨论相关细节。这一举措反映出公司在技术保密和信息安全方面的高度重视,也体现了对敏感信息管理的严谨态度。在当前人工智能技术快速发展的背景下,此类措施有助于防止关键技术外泄,维护企业的核心竞争力。同时,这也提醒我们,随着AI技术的不断突破,相关研发过程中的安全与合规问题将愈发受到关注。

同时,公司已实施多项物理与网络安全强化措施:核心专有技术被存储在隔离的离线计算机系统中;办公区域内配备了生物识别门禁系统,如指纹识别;同时推行“默认拒绝”的互联网访问政策,所有外部连接必须经过明确授权。报道还提到,OpenAI已大幅提高数据中心的物理安全标准,并显著扩大了网络安全团队的规模。

分析认为,这些举措直接体现了业界对外国势力窃取OpenAI知识产权的广泛担忧。同时,鉴于美国人工智能领域人才竞争日趋激烈,以及近期公司内部频繁发生的信息泄露事件(如CEO萨姆·奥特曼的内部发言外泄),OpenAI此次加强安全措施,也旨在应对内部潜在的安全风险。 我认为,随着AI技术的重要性不断提升,企业对知识产权和内部信息的保护将变得更加关键。OpenAI此举不仅反映出对外部威胁的警觉,也显示出对内部管理漏洞的重视。在人才流动频繁的背景下,如何平衡开放创新与信息安全,将成为行业面临的重要课题。

人工智能最新资讯

魅族22震撼登场:1.5K 120Hz LTPO屏,1800尼特亮度重塑视觉新体验

2025-09-09 10:53:20

33岁女性靠维修无人机年赚500万,未来要进军机器狗维修领域

2025-09-09 10:26:34

三防黑科技来袭!Jeep多巴胺冲锋衣限时特惠89.9元,抢鲜入手正当时

2025-09-09 10:22:01

人形机器人首秀卖爆米花,特斯拉AI开启未来互动新场景

2025-09-09 10:00:54

一箭11星!吉利星座第五轨成功升空,领克涂装火箭闪耀太空

2025-09-09 09:47:55

华为Mate XTS三折叠手机首发星闪车钥匙,鸿蒙HarmonyOS 6.0全面赋能智能生态

2025-09-09 09:41:51

火狐新功能来袭:原生分屏模式让双网页浏览更高效便捷

2025-09-09 09:31:15

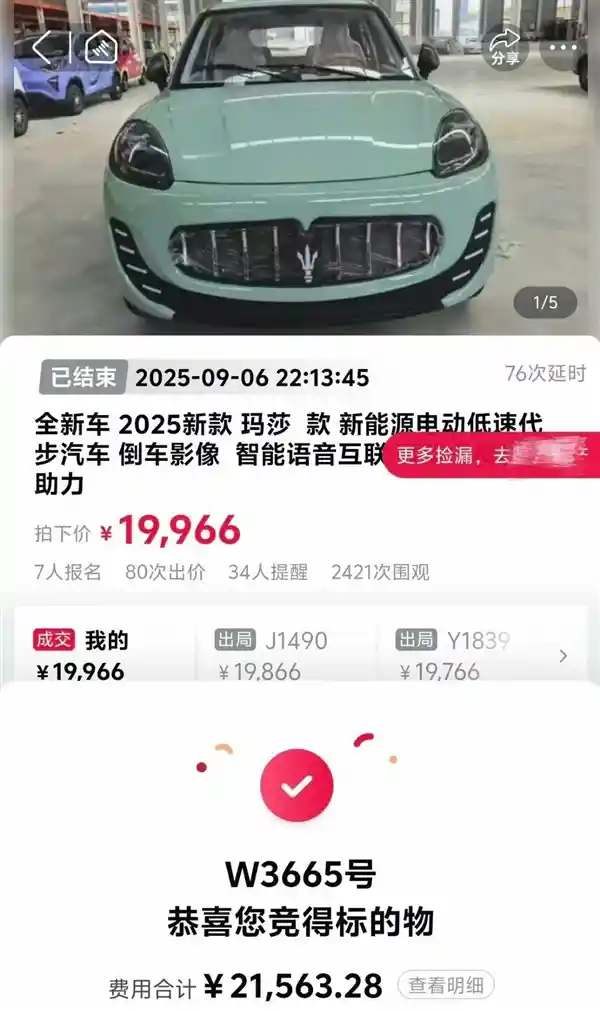

男子花2万拍下玛莎拉蒂竟成老头乐,涉事机构同意悔拍

2025-09-09 09:20:45

小米澎湃OS 3接入12306引热议:行程提醒异常问题引发关注

2025-09-09 08:45:29

华为季度出货量破千万,登顶全球腕戴设备榜首

2025-09-09 08:43:24

王腾未被辞退?知情人士:与泄露定价策略无关

2025-09-09 08:43:10

微信鸿蒙版1.0.10.36重磅上线:新增锁屏接听语音通话,八大新功能引领体验升级

2025-09-09 08:42:10

别等了!Windows 更新可能要停了?

2025-09-09 08:41:03

追觅进军欧洲!2027年超豪华纯电车对标布加迪,德国建厂引爆行业

2025-09-09 08:35:42

苹果 Apple Watch 收入破千亿,智能穿戴开启新纪元

2025-09-09 08:32:38

腾讯《穿越火线》鸿蒙版来袭,手游全面适配手机平板开启前瞻测试

2025-09-09 08:31:08

《战酋》取景地秒变打卡热点,苹果地图开启追剧新体验

2025-09-09 08:29:09

马斯克豪掷170亿!SpaceX抢滩无线频谱新战场

2025-09-09 08:27:23

苹果 iPhone 17 电池曝光,联通获卫星通信牌照,王腾回应离职风波

2025-09-09 08:25:57

美团闪购推出行业首项退货免运费服务,购物更无忧

2025-09-05 14:17:14

网民辱华言论遭严惩,襄阳警方强势回应九三阅兵风波

2025-09-05 14:03:29

真我15系列震撼官宣:9月16日开启夜拍新纪元

2025-09-05 13:52:40

马斯克缺席!特朗普宴请科技巨头,库克扎克伯格现身

2025-09-05 12:55:16

苹果卷入新专利风波:Cerence指控其语音技术侵权,或波及Siri与CarPlay

2025-09-05 12:54:17

小米服务小程序上线:一键掌握服务全流程与费用详情